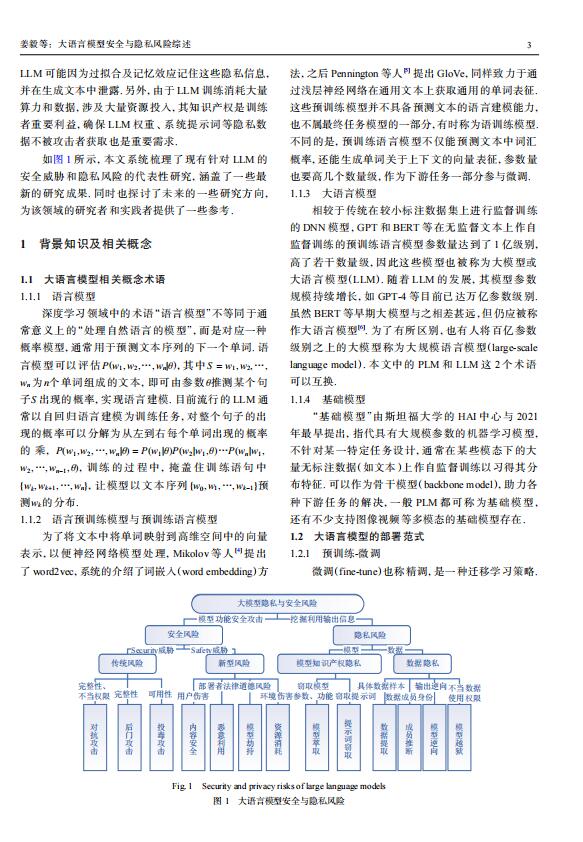

资料内容:

1.1 大语言模型相关概念术语

1.1.1 语言模型

P(w1,w2,…,wn |θ) S = w1,w2,…,

wn n θ

S

P(w1,w2,…,wn |θ) = P(w1|θ)P(w2|w1, θ)…P(wn|w1,

w2,…,wn−1 , θ)

{wk ,wk+1,…,wn } {w0 ,w1,…,wk−1 }

wk

深度学习领域中的术语“语言模型”不等同于通

常意义上的“处理自然语言的模型”,而是对应一种

概率模型,通常用于预测文本序列的下一个单词. 语

言模型可以评估 ,其中

为 个单词组成的文本,即可由参数 推测某个句

子 出现的概率,实现语言建模. 目前流行的 LLM 通

常以自回归语言建模为训练任务,对整个句子的出

现的概率可以分解为从左到右每个单词出现的概率

的 乘,

, 训练的过程中 , 掩盖住训练语句中

,让模型以文本序列 预

测 的分布.

1.1.2 语言预训练模型与预训练语言模型

为了将文本中将单词映射到高维空间中的向量

表示,以便神经网络模型处理,Mikolov 等人[4] 提出

了 word2vec,系统的介绍了词嵌入(word embedding)方

法,之后 Pennington 等人[5] 提出 GloVe,同样致力于通

过浅层神经网络在通用文本上获取通用的单词表征.

这些预训练模型并不具备预测文本的语言建模能力,

也不属最终任务模型的一部分,有时称为语训练模型.

不同的是,预训练语言模型不仅能预测文本中词汇

概率,还能生成单词关于上下文的向量表征,参数量

也要高几个数量级,作为下游任务一部分参与微调.

1.1.3 大语言模型

相较于传统在较小标注数据集上进行监督训练

的 DNN 模型,GPT 和 BERT 等在无监督文本上作自

监督训练的预训练语言模型参数量达到了 1 亿级别,

高了若干数量级,因此这些模型也被称为大模型或

大语言模型(LLM). 随着 LLM 的发展,其模型参数

规模持续增长,如 GPT-4 等目前已达万亿参数级别.

虽然 BERT 等早期大模型与之相差甚远,但仍应被称

作大语言模型[6] . 为了有所区别,也有人将百亿参数

级别之上的大模型称为大规模语言模型(large-scale

language model). 本文中的 PLM 和 LLM 这 2 个术语

可以互换.

1.1.4 基础模型

“基础模型”由斯坦福大学的 HAI 中心与 2021

年最早提出,指代具有大规模参数的机器学习模型,

不针对某一特定任务设计,通常在某些模态下的大

量无标注数据(如文本)上作自监督训练以习得其分

布特征. 可以作为骨干模型(backbone model),助力各

种下游任务的解决,一般 PLM 都可称为基础模型,

还有不少支持图像视频等多模态的基础模型存在.