资料内容:

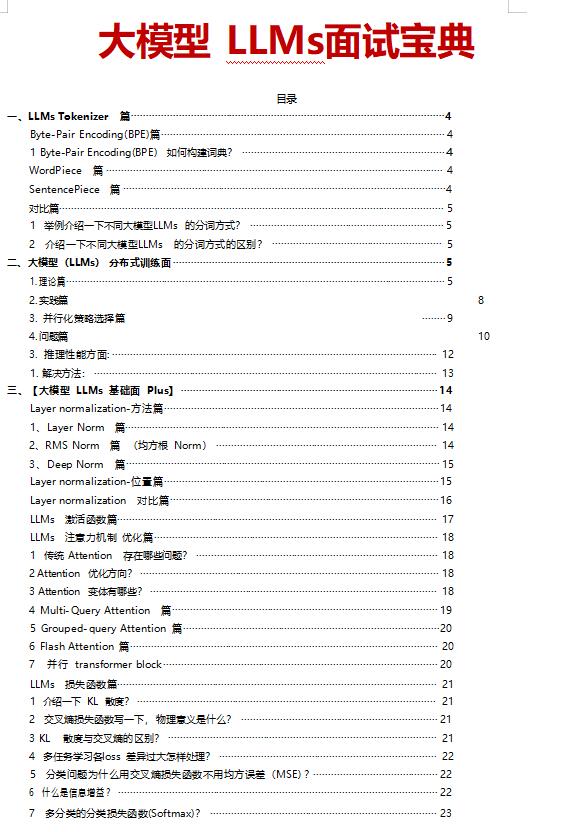

Byte-Pair Encoding(BPE)篇

1 Byte-Pair Encoding(BPE) 如何构建词典?

1 准备足够的训练语料;以及期望的词表大小;

2 将单词拆分为字符粒度(字粒度), 并在末尾添加后缀“”, 统计单词频率

3 合并方式:统计每一个连续/相邻字节对的出现频率, 将最高频的连续字节对合并为新字词;

4 重复第 3 步, 直到词表达到设定的词表大小;或下一个最高频字节对出现频率为 1。 注: GPT2 、BART 和 LLaMA 就采用了BPE。

Word Piece 篇

Word Piece 与 BPE 异同点是什么?

本质上还是BPE 的思想。与BPE 最大区别在于:如何选择两个子词进行合并 BPE 是选择频次最大 的相邻子词合并;

Word Piece 算法选择能够提升语言模型概率最大的相邻子词进行合并, 来加入词表; 注: BERT 采用了 Word Piece。

SentencePiece 篇

简单介绍一下 SentencePiece 思路?

把空格也当作一种特殊字符来处理,再用BPE 或者来构造词汇表。 注:ChatGLM 、BLOOM 、 PaLM 采用了SentencePiece。